Künstliche Intelligenz: Die digitale Zukunft in der Pflege gestalten. 9. Fachtagung Technik – Ethik – Gesundheit

Künstliche Intelligenz: Die digitale Zukunft in der Pflege gestalten. 9. Fachtagung Technik – Ethik – Gesundheit

Menschenzentrierte XAI in der Altenpflege: Erste Learnings aus der Entwicklung eines partizipativen Frameworks

Text

Einleitung

Künstliche Intelligenz (KI) birgt großes Potenzial für die Altenpflege, etwa durch die Automatisierung von Routineaufgaben, die Analyse von Sensordaten und die Generierung umsetzbarer Empfehlungen. Ziel ist eine höhere Effizienz, damit Pflegekräfte sich stärker auf zwischenmenschliche Aspekte konzentrieren können [1], [2], [3]. Die Integration in bestehende Arbeitsabläufe ist jedoch herausfordernd, da Fehlinterpretationen oder Systemfehler schwerwiegende Folgen haben können. Vertrauen und Transparenz sind daher entscheidend. Erklärbare KI (XAI) adressiert diese Herausforderungen mit transparenten, nutzungsnahen Systemen – ein Aspekt, der in der XAI-Entwicklung häufig vernachlässigt wird. Besonders in sicherheitskritischen Bereichen wie der Altenpflege erschweren unterschiedliche mentale Modelle, Begriffe und Erwartungen zwischen Pflegekräften und Entwickler:innen die Umsetzung [4], [5]. Missverständnisse beeinträchtigen Vertrauen und Nutzbarkeit [6]. Partizipative Methoden wie Personas, Customer Journey Mapping (CJM) und szenariobasiertes Prototyping fördern das Verständnis von Nutzendenbedürfnissen und helfen, divergierende Arbeitsabläufe zu überbrücken [7], [8], [9], [10]. Ihre Anwendung auf XAI in der Pflege ist bislang kaum untersucht [11]. Dieses Paper stellt das HCXAI-Framework vor – einen partizipativen Designansatz, der bewährte Methoden anpasst, um intelligente Benutzungsschnittstellen (IUIs) mit den Arbeitsroutinen in der Pflege zu verknüpfen. Forschungsleitend ist die Frage: Wie können partizipative Methoden eine gemeinsame Kommunikationsbasis schaffen, um die Entwicklung erklärbarer, pflegekompatibler KI-Systeme zu fördern? Die Studie basiert auf interdisziplinären Workshops und ethnografischer Feldforschung und zeigt, wie partizipative Methoden kritische Nutzendenanforderungen sichtbar machen und vertrauenswürdige, adaptive KI-Lösungen unterstützen.

Verwandte Arbeiten

Erklärbare KI (XAI) macht komplexe Modelle interpretierbar und umsetzbar – besonders wichtig in sicherheitskritischen Bereichen mit nicht-technischen Nutzenden [1], [12]. Während frühe XAI-Forschung algorithmische Transparenz fokussierte, betonen aktuelle Ansätze kontextsensitive Erklärungen, die auf Nutzungsabläufe und bereichsspezifische Entscheidungsprozesse abgestimmt sind [13], [14], [15]. Anpassungsfähige, kontrastive Erklärungen fördern Vertrauen, indem sie zeigen, wie Systeme entscheiden, nicht nur warum [16], [17]. Lokale Erklärungen beleuchten Einzelentscheidungen, globale Erklärungen liefern Muster – beide sind in der Altenpflege essenziell [18], [19]. Partizipative Methoden aus der Mensch-Computer-Interaktion (HCI) beziehen Nutzende wirksam ins technische Design ein, besonders im interdisziplinären Kontext. Co-Design-Workshops fördern gemeinsames Verständnis und sorgen für robuste, verständliche Systeme. Mucha et al. [6] zeigen, wie Interface-Skizzen interdisziplinäre Lücken schließen und klinisch nutzbare Erkenntnisse generieren. Die Gestaltung effektiver Erklärungsschnittstellen bleibt jedoch herausfordernd. Shneiderman [19] betont, dass Mensch-Maschine-Interaktion nicht menschliche Kommunikation imitieren sollte, sondern deren Besonderheiten nutzt. Prägnante, relevante Erklärungen sind insbesondere in sicherheitskritischen Kontexten bevorzugt [13]. Moderne KI, insbesondere maschinelles Lernen, erfordert Post-hoc-Techniken wie Merkmalszuordnung oder beispielbasierte Erklärungen ([2], [18], Martens 2014). Diese liefern wertvolle Einblicke, adressieren jedoch oft nicht die Bedürfnisse nicht-technischer Nutzender. Szenariobasierte Ansätze wie bei Ehsan et al. [20] richten technische Funktionalitäten an den Arbeitsabläufen der Nutzenden aus und fördern deren Verständnis. Trotz Fortschritten bleibt die Anwendung partizipativer Methoden in der Pflege untererforscht. Werkzeuge wie CJM strukturieren interdisziplinäre Diskussionen und decken prozessuale Engpässe auf ([1], Wang 2019). Hemmer et al. [21] zeigen, wie Delegationsstrategien zwischen KI und Menschen Vertrauen und Leistung verbessern und gemeinsame Entscheidungen unterstützen. Partizipative Methoden entsprechen den Prinzipien des User-Centered Design (UCD) gemäß ISO 9241-210:2019. UCD umfasst iterative Phasen zur Kontextanalyse, Anforderungsspezifikation, Lösungsgestaltung und Evaluation. Erweiterte Ansätze wie DoReMi [22] oder fragengetriebene Designs [23] binden Nutzende stärker ein, bleiben aber oft auf Feedback beschränkt. Das HCXAI-Framework schließt diese Lücke durch kontinuierliche Zusammenarbeit und geteiltes Verständnis im gesamten Designprozess. Die Methoden sind nicht nur für die Altenpflege relevant, sondern auch auf andere sicherheitskritische Bereiche wie das Gesundheitswesen, den Katastrophenschutz oder die Industrie übertragbar.

Methoden

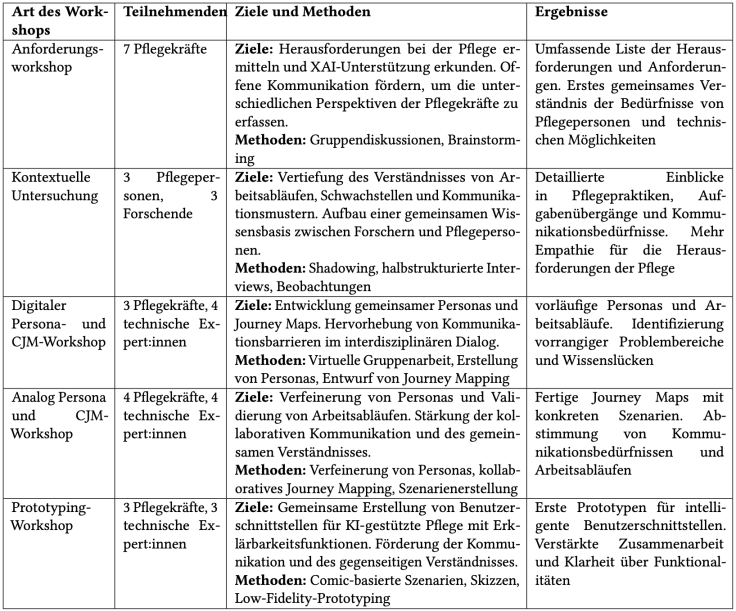

Unser partizipativer Forschungsansatz zielte darauf ab, ein auf die Bedürfnisse von Pflegekräften zugeschnittenes XAI-Framework zu entwickeln, das Kommunikations- und Designlücken zwischen Pflege und Technik überbrückt. Der Schwerpunkt lag auf kontextsensitiven Erklärungen, benutzendenzentriertem Design und interdisziplinärer Zusammenarbeit. Aufbauend auf früheren Arbeiten zu partizipativen Methoden in der XAI [7], [10] umfasste der Prozess mehrere Workshops und eine ethnografische Feldstudie (siehe Tabelle 1 [Tab. 1]). Angepasste Tools wie Personas, Customer Journey Mapping (CJM) und comicbasierte Szenarien unterstützten die Entwicklung gemeinsamer Verständnisse und prototypischer Lösungen. Techniken wie das Skizzieren von Prototypen halfen, abstrakte Konzepte zu visualisieren und disziplinäre Barrieren zu überwinden.

Tabelle 1: Überblick über Workshops, Methoden und Ergebnisse

Die Forschung begann mit einem Anforderungsworkshop und einer kontextbezogenen Analyse, deren Erkenntnisse in die Gestaltung und Adaption der Methoden einflossen. Drei Workshops wurden – teils digital, teils analog – mit insgesamt 14 Teilnehmenden (Pflegekräfte und technische Fachpersonen) durchgeführt. Die Sitzungen dauerten jeweils 2–4 Stunden und wurden von erfahrenen Forschenden moderiert. Aufeinander aufbauende Workshopzyklen ermöglichten es, Tools iterativ zu verfeinern, terminologische Lücken zu schließen und Prototypen gemeinsam zu entwickeln.

Erhoben wurden Workshop-Protokolle, Beobachtungsnotizen, visuelle Artefakte und Teilnehmendenfeedback. Eine qualitative Inhaltsanalyse nach Mayring [24] kombinierte deduktive Kategorien (z. B. Benutzendenfreundlichkeit, Transparenz) mit induktiven Themen, die im Verlauf der Analyse entstanden. Die Triangulation mehrerer Datenquellen sowie der Abgleich von Transkripten, Artefakten und Notizen erhöhten Validität und Tiefe der Ergebnisse. Iterative Feedbackrunden mit den Teilnehmenden sicherten deren Rückhalt und stellten Passung zu ihren Erwartungen sicher.

Ergebnisse und Diskussion

Die eingesetzten partizipativen Methoden förderten gegenseitiges Verständnis und führten zu umsetzbaren Ergebnissen. Der Anforderungsworkshop identifizierte zentrale Kommunikationsbarrieren, etwa unterschiedliche Denkmodelle und Fachsprachen, und verdeutlichte die Bedeutung partizipativer Ansätze zur Bewältigung interdisziplinärer Herausforderungen. Die kontextbezogene Analyse ergänzte dies durch praxisnahe Einblicke in Pflegeprozesse, etwa Schichtplanung und Dokumentation, und zeigte potenzielle Einsatzbereiche für KI. Zwar förderte sie nicht direkt die Zusammenarbeit, lieferte aber wichtige Grundlagen für die weiteren Workshops.

Persona- und CJM-Workshops waren entscheidend für die Perspektivangleichung. Durch strukturierte Dialoge und visuelle Aufbereitung konnten Engpässe wie der verzögerte Zugriff auf Patientendaten sichtbar gemacht werden. Komplexe Pflegeabläufe erschwerten teilweise den Fortschritt, insbesondere bei rollenspezifischen Wissensunterschieden. Vorlagen und gezielte Moderation – wie von Hemmer et al. empfohlen [21] – könnten hier künftig unterstützen. Personas stärkten die Zusammenarbeit, indem sie Pflegeberufe greifbar machten, das Engagement erhöhten und technische Diskussionen kontextualisierten – im Einklang mit den Erkenntnissen von Weitz et al. [7].

Der Prototyping-Workshop bestätigte die Nützlichkeit des Frameworks zur Entwicklung praxisnaher Designartefakte. Papierprototypen verknüpften Pflegeabläufe mit kontextsensitiven KI-Erklärungen. Comic-basierte Szenarien halfen, abstrakte Konzepte zu veranschaulichen; gemeinsames Skizzieren überführte technische Ideen in nutzernahe Prototypen. Dabei zeigte sich: Zu detaillierte Entwürfe können nicht-technische Teilnehmende überfordern [7]. Die Ergebnisse unterstreichen – in Übereinstimmung mit früheren Co-Design-Studien in sicherheitskritischen Kontexten – die Relevanz visueller Hilfsmittel und strukturierter Dialoge [25].

Kontextsensitive Erklärungen, zugeschnitten auf konkrete Szenarien, erwiesen sich als zentral für Vertrauen und Benutzendenfreundlichkeit. Die Differenzierung lokaler (situativer) und globaler (schulungsbezogener) Erklärungen folgt den Empfehlungen von Miller [13]. Feedbackschleifen zur Verfeinerung von KI-Empfehlungen förderten Vertrauen und Anpassbarkeit [16]. Terminologielücken blieben eine Herausforderung. Visuelle Tools wie Personas und CJMs milderten Missverständnisse, könnten aber durch Glossare oder strukturierte Leitfäden ergänzt werden [8]. Insgesamt zeigte das HCXAI-Framework hohe Anpassungsfähigkeit und Effektivität in interdisziplinären Settings. Analoge Workshops überwanden Kommunikationsbarrieren besser als digitale Formate, die durch technische Einschränkungen limitiert waren. Künftige Anwendungen sollten flexibel und iterativ ausgestaltet werden, um unterschiedlichen Teilnehmendenbedürfnissen gerecht zu werden.

Fazit und Ausblick

Diese Studie stellte das HCXAI-Framework vor, das zeigt, wie partizipative Methoden eine gemeinsame Kommunikationsbasis schaffen und das gegenseitige Verständnis zwischen Pflegekräften und technischen Fachpersonen fördern können. Durch angepasste Ansätze wie Customer Journey Mapping, Personas, szenariobasiertes Design und Papierprototyping wurden technische Lösungen gezielt mit Pflegearbeitsabläufen verzahnt und interdisziplinäre Lücken geschlossen. Die Ergebnisse verdeutlichen die Relevanz einer geteilten Kommunikationsgrundlage im partizipativen Designprozess. Frühe Phasen wie Anforderungsworkshops und kontextbezogene Analysen verankerten die Methodenauswahl in realen Praxisanforderungen. Werkzeuge wie Personas und kollaboratives Skizzieren übersetzten technische Konzepte in greifbare Pflegeszenarien, stärkten das Vertrauen und förderten aktives Engagement. Erklärbarkeit muss dabei über algorithmische Transparenz hinausgehen und kontextsensitive, handlungsrelevante Einsichten liefern, die sich nahtlos in bestehende Abläufe integrieren lassen.

Zukünftige Forschung sollte die langfristige Wirksamkeit des Frameworks in realen Pflegeumgebungen evaluieren – etwa im Hinblick auf Effizienz, Vertrauen und Akzeptanz. Die Beteiligung weiterer Stakeholder, darunter Angehörige, Verwaltungsangestellte und Bewohner:innen, könnte ein umfassenderes Bild des Pflegeökosystems ermöglichen. Eine Verfeinerung von Methoden wie dem CJM, um Verständlichkeit und technische Tiefe besser auszubalancieren, kann die Wirkung partizipativer Ansätze weiter steigern.

Die Übertragung des Frameworks auf andere sicherheitskritische Bereiche wie Gesundheitsdiagnostik oder Katastrophenschutz bietet Chancen zur Validierung seiner Anpassungsfähigkeit. Die Ableitung praxisnaher Gestaltungsrichtlinien aus dieser und künftigen Studien kann Forschende und Praktiker:innen bei der Entwicklung kontextsensitiver, benutzungsfreundlicher und interdisziplinär anschlussfähiger XAI-Systeme unterstützen. Das HCXAI-Framework bietet somit eine robuste Grundlage für vertrauenswürdige, adaptive KI-Systeme, die technische Leistungsfähigkeit und menschliche Bedürfnisse erfolgreich integrieren.

Literatur

[1] Hughes R, Edmond C, Wells L, et al. EXplainable AI (XAI): An introduction to the XAI landscape with practical examples. In: SA ’20: SIGGRAPH Asia 2020; 2020 Dec 4-13. ACM; 2020. DOI: 10.1145/3415263.3419166[2] Guidotti R, Monreale A, Ruggieri S, Turini F, Giannotti F, Pedreschi D. A survey of methods for explaining black box models. ACM computing surveys (CSUR). 2018;51(5):1-42.

[3] Wolf CT. Explainability scenarios: Towards scenario-based XAI design. In: IUI ’19: 24th International Conference on Intelligent User Interfaces; 2019 Mar 16-20; Marina del Ray, CA, USA. ACM; 2019. p. 252-7. DOI: 10.1145/3301275.3302317

[4] Rouse WB, Morris NM. On looking into the black box: Prospects and limits in the search for mental models. Psychological Bulletin. 1986;100(3):349-63.

[5] Holzinger A, Langs G, Denk H, Zatloukal K, Müller H. Causability and explainability of artificial intelligence in medicine. Wiley Interdisciplinary Reviews: Data Mining and Knowledge Discovery. 2019;9(4):e1312.

[6] Mucha H, Robert S, Breitschwerdt R, Fellmann M. Usability of clinical decision support systems. Zeitschrift für Arbeitswissenschaft. 2023;77:92-101.

[7] Weitz K, Schlagowski R, André E, Männiste M, George C. Explaining It Your Way - Findings from a Co-Creative Design Workshop on Designing XAI Applications with AI End-Users from the Public Sector. In: CHI ’24: CHI Conference on Human Factors in Computing Systems; 2024 May 11-16; Honolulu, HI, USA. ACM; 2024. DOI: 10.1145/3613904.3642563

[8] Delgado F, et al. Stakeholder Participation in AI: Beyond “Add Diverse Stakeholders and Stir”. In: NeurIPS 2021. Thirty-Fifth Annual Conference on Neural Information Processing Systems; 2021 Dec 6-14.

[9] Stickdorn M, Schneider J. This is Service Design Thinking: Basics, Tools, Cases. Wiley; 2011.

[10] Mucha H, Robert S, Mevissen D, Jacobi R, Meyer K, Heusler W, et al. Co-Design Futures for AI and Space: A Workbook Sprint. In: CHI EA ’20: Extended Abstracts of the 2020 CHI Conference on Human Factors in Computing Systems; 2020 Apr 25-30; Honolulu, HI, USA. ACM; 2020. DOI: 10.1145/3334480.3375203

[11] Wolf C. Explainability scenarios: towards scenario-based XAI design. In: CHI ’19: CHI Conference on Human Factors in Computing Systems; 2019 May 4-9; Glasgow, Scotland, UK. ACM; 2019. p. 252-7. DOI: 10.1145/3301275.330231

[12] Vilone G, Longo L. Explainable Artificial Intelligence: A Systematic Review [Preprint]. arXiv. 2020. DOI: 10.48550/arXiv.2006.00093

[13] Miller T. Explanation in Artificial Intelligence: Insights from the Social Sciences. Artificial Intelligence. 2019;267:1-38. DOI: 10.1016/j.artint.2018.07.007

[14] Brennen A. What do people really want when they say they want explainable AI? In: CHI EA ’20: Extended Abstracts of the 2020 CHI Conference on Human Factors in Computing Systems; 2020 Apr 25-30; Honolulu, HI, USA. ACM; 2020. DOI: 10.1145/3334480.3383047

[15] Schmidt A. Interactive Human-Centered Artificial Intelligence: A Definition and Research Challenges. In: AVI '20: Proceedings of the 2020 International Conference on Advanced Visual Interfaces; 2020 Sep 28 - Oct 2; Salerno, Italy. ACM; 2020. DOI: 10.1145/3399715.3400873

[16] Wintersberger P, Nicklas H, Martlbauer T, et al. Explainable Automation: Personalized and Adaptive UIs to Foster Trust and Understanding of Driving Automation Systems. In: AutomotiveUI ’20: 12th International Conference on Automotive User Interfaces and Interactive Vehicular Applications; 2020 Sep 21-22. ACM; 2020. p. 252-61. DOI: 10.1145/3409120.341065

[17] Kasirzadeh A. Reasons, Values, Stakeholders: A Philosophical Framework for Explainable Artificial Intelligence. In: FAccT '21: Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency; 2021 Mar 3-10. ACM; 2021. p. 14. DOI: 10.1145/3442188.344586

[18] Gilpin LH, Bau D, Yuan BZ, Bajwa A, Specter M, Kagal L. Explaining explanations: An overview of interpretability of machine learning. In: 2018 IEEE 5th International Conference on Data Science and Advanced Analytics; 2018 Oct 1-3; Turin, Italy. IEEE; 2028. p. 80-9. DOI: 10.1109/DSAA.2018.00018

[19] Shneiderman B. Bridging the Gap Between Ethics and Practice: Guidelines for Reliable, Safe, and Trustworthy Human-Centered AI. ACM Transactions on Interactive Intelligent Systems. 2020;10(4):26. DOI: 10.1145/3419764

[20] Ehsan U, Harrison B, Chan M, Riedl MO. Automated rationale generation: A technique for explainable AI and its effects on human perceptions. In: IUI ’19: Proceedings of the 24th International Conference on Intelligent User Interfaces; 2019 Mar 17-20; Marina del Ray, CA, USA. ACM; 2019. p. 263-74. DOI: 10.1145/3301275.330231

[21] Hemmer P, Westphal M, Schemmer M, et al. Human-AI Collaboration: The Effect of AI Delegation on Human Task Performance and Task Satisfaction. In: IUI ’23: 28th International Conference on Intelligent User Interfaces; 2023 Mar 27-31; Sydney, NSW, Australia. ACM; 2023. p. 453-63. DOI: 10.1145/3581641.3584052

[22] Schoonderwoerd A, de Bruijn O, Klievink B. DoReMi-Practice: A Framework for Human-Centered Design in XAI. AI & Society. 2021;36:483-98.

[23] Liao QV, Gruen D, Miller T. Questioning the AI: Informing Design Practices for Explainable AI User Experiences. In: CHI ’20: CHI Conference on Human Factors in Computing Systems; 2020 Apr 25-30; Honolulu, HI, USA. ACM; 2020. p. 1-15. DOI: 10.1145/3313831.3376590

[24] Mayring P. Qualitative Inhaltsanalyse: Grundlagen und Techniken. Weinheim, Basel: Beltz Verlagsgruppe; 2015.

[25] Ribera M, Lapedriza A. Can we do better explanations? A proposal of user-centered explainable AI. 2019.